Hai Rekan Devs,

Pie kabare ? Semoga sehat” terus dan joss. Punten uda lama juga ga coret-coret disini, biasa sok sibuk biar keliatan kaya kerja. Nah kali ini kita coba bikin tool kecil yang bisa menjalankan model generative di pc sendiri. Saat ini ada beberapa tools serupa yaitu:

- Ollama: https://ollama.com/

- LM Studio: https://lmstudio.ai/

- LocalAI: https://localai.io/

Pertanyaannya, uda banyak kenapa bikin lagi ? jawabannya, kenapa enggak haha…

Nah, intinya kita sama-sama belajar aja daripada nge-gosip ngomongin pemerintah mulu ye khaan. Nah, tool ini dibuat pakai onnx generative library, yang memungkinkan kita ngejalanin model dengan format onnx di pc sendiri. Kelebihannya selain portable, model juga bisa dioptimasi dengan resource yang dimiliki misal ada cpu, gpu, npu. Ga usa musingin implementasi yang berbeda, udah di abstraksi di library ini.

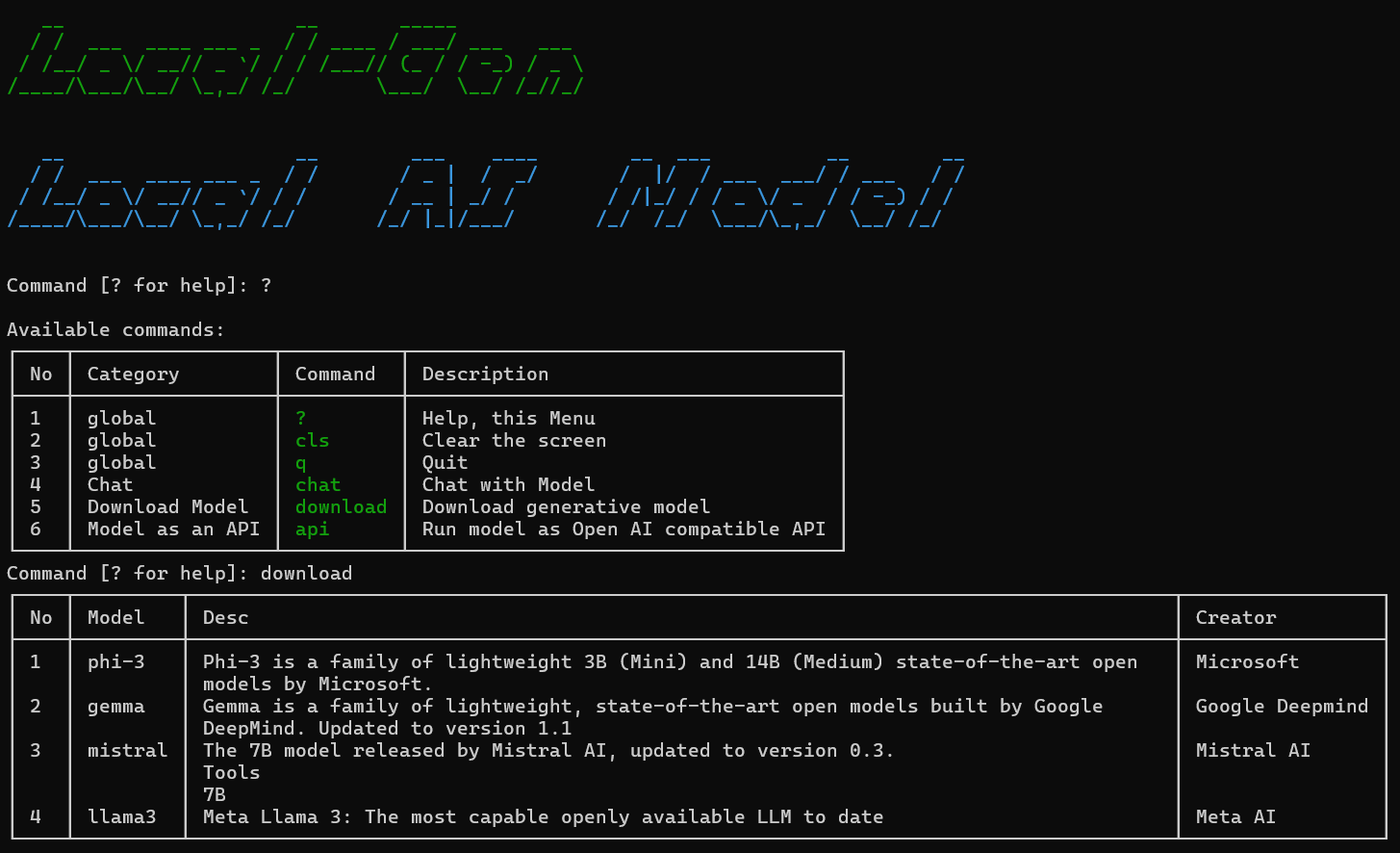

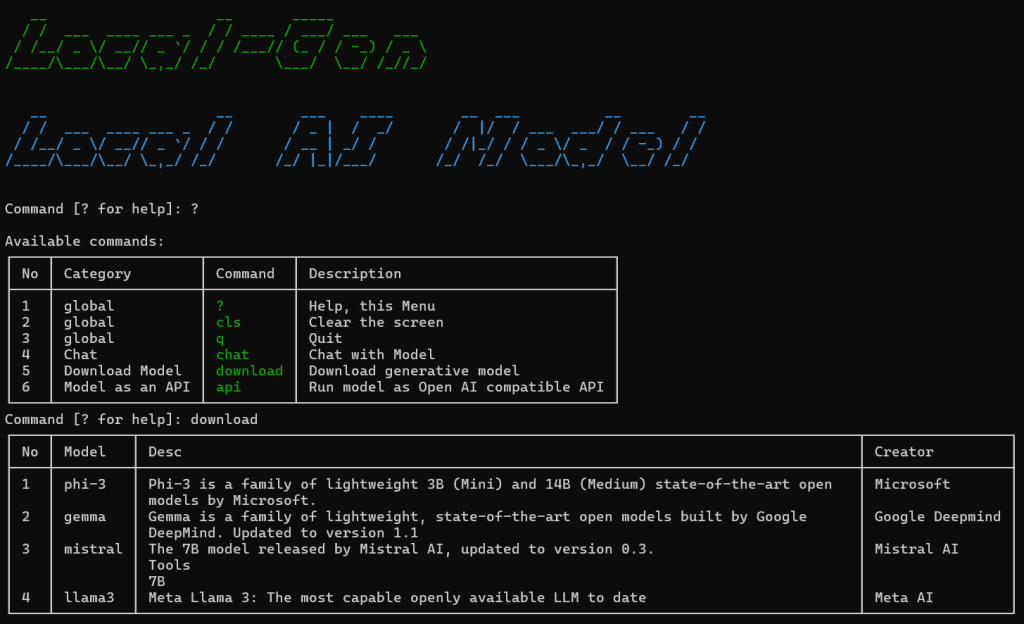

Oke, uda ga tahan ni kebanyakan teori mo langsung jajal aja, yaude sok coba ikutin langkahnya:

- Clone repo-nya dari: https://github.com/Gravicode/localgen

- Buka pake visual studio community / vscode atau via terminal langsung

- Run teken ‘F5’ atau dari Cli buka ke folder ‘localgen’ ketik ‘dotnet run’

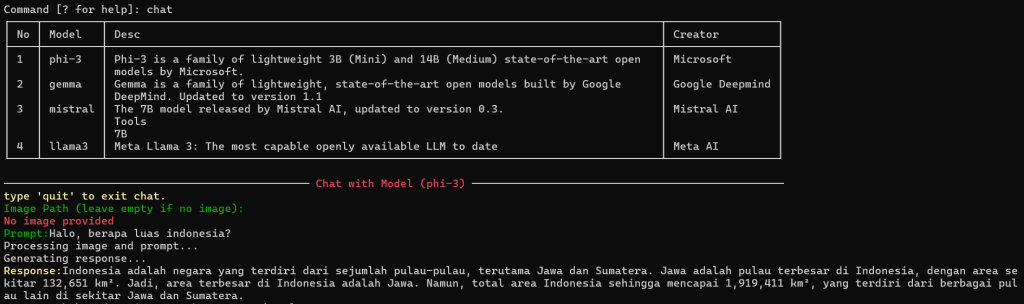

- Uda deh abis itu ngerti sendiri cara pakenya karena toolnya walaupun di cli tetep menyediakan interface yang mudah dan memiliki keterangan yang jelas.

Saat ini fiturnya sebagai berikut:

- Chat dengan Model

- Serve Model sebagai API yang compatible dengan Open AI API Completion

- Download model

Semoga bermanfaat, silakan masih banyak celah untuk dikembangin lagi, kirim PR-lah biar open source di indo makin maju.

Salam Coder ;D

![]()