Hi Rekan Devs,

Ya sekarang mulai rame lagi menjalankan model generative di PC/Smartphone ya, itung-itung bantu jualannya pembuat chip gpu/npu haha. Untuk temen-temen yang concern banget mengenai data/dokumen yang digunakan karena mungkin sifatnya rahasia (banyak aib-nya) tentu ini menjadi hal yang penting untuk tidak dibagikan ke pihak lain (misal: penyedia cloud provider).

Microsoft di acara BUILD 2024 mengumumkan model SLM (small language model) mereka yang bernama Phi-3, karena ukuran relatif kecil bisa jalan di PC / Smartphone temen-temen, tapi ya sadar diri lah yang chip GPU-nya aga fakir ya. Nah pada salah satu sesi BUILD 2024, ada demo RAG: Zero to Hero – Develop your first app with Local LLMs on Windows | BRK142 – YouTube tapi sayangnya pas di run contoh codenya bermasalah. Akhirnya penulis bantu untuk modifikasi projectnya agar bisa run di .Net 8 dan mengganti beberapa bagian code dan librarynya.

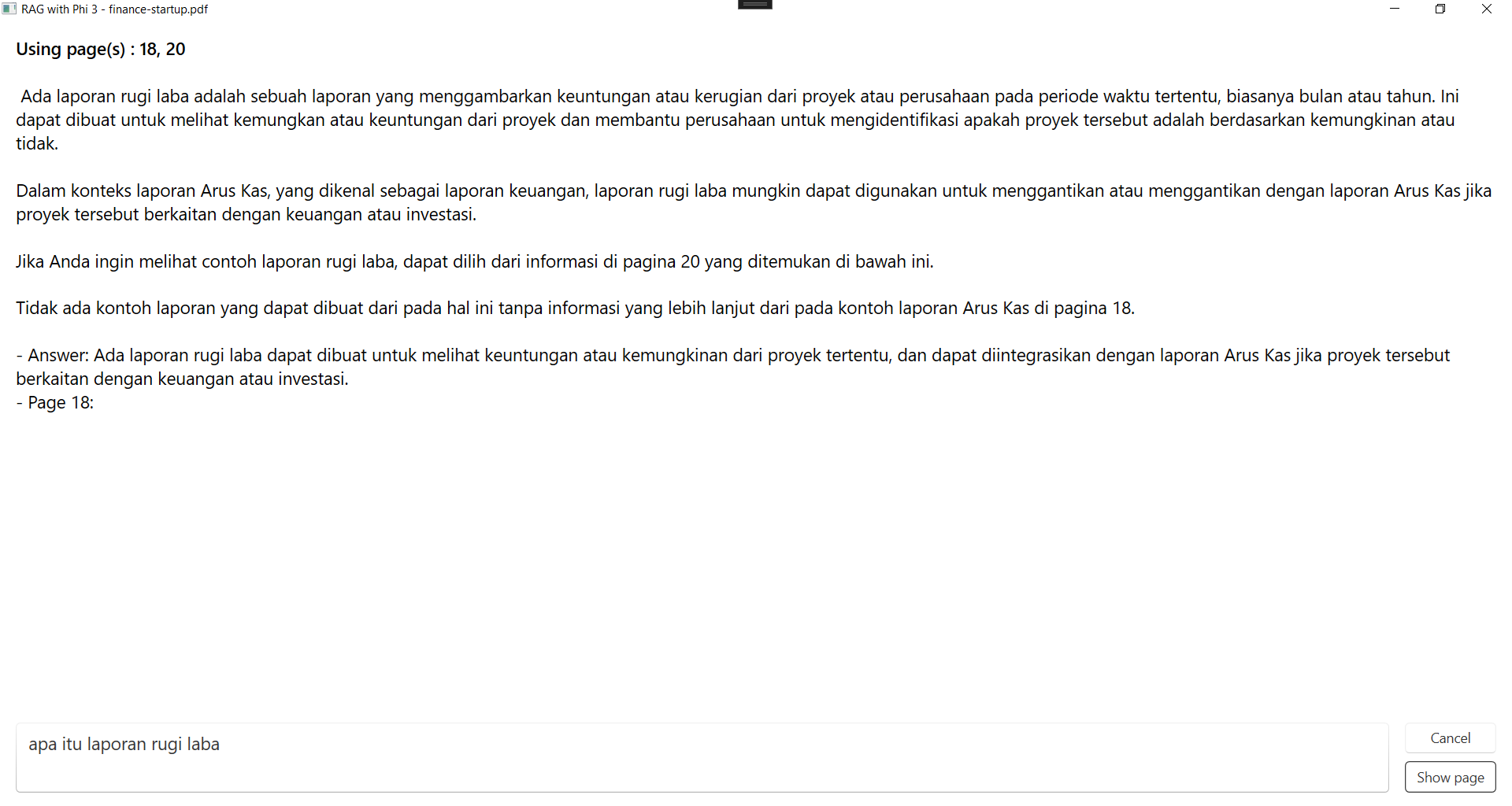

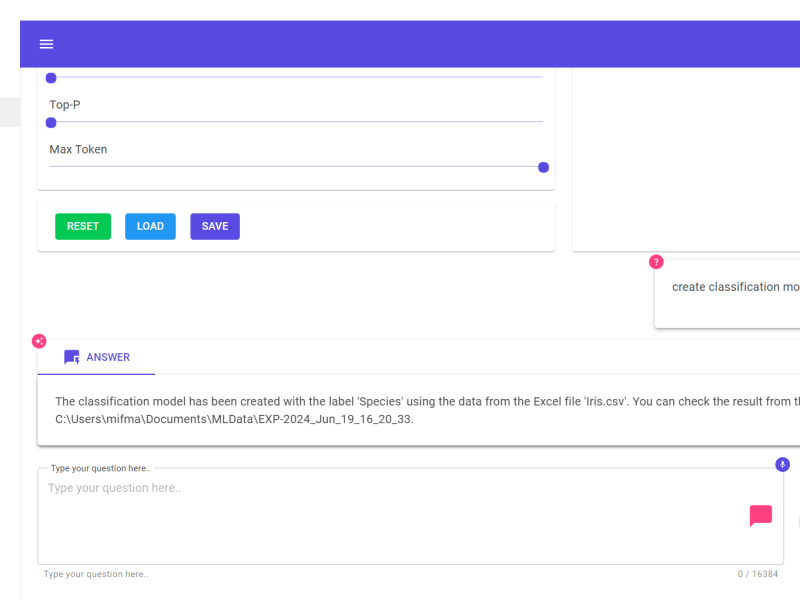

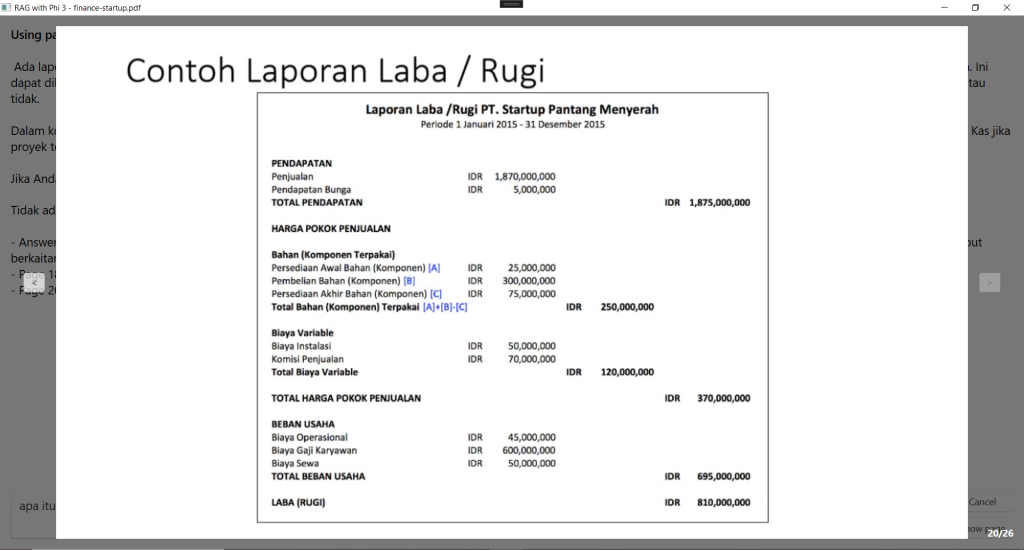

Oke, kali ini kita akan coba model ini untuk menjawab pertanyaan terkait dokumen yang kita jadikan sebagai referensi. Tekniknya bernama RAG (retrieval augmented generative), intinya kita ambil bagian dari dokumen tersebut yang punya relevansi tinggi dengan prompt dari user sebagai konteks tambahan untuk menjawab pertanyaan dengan tepat, dan ga halusinasi ;D

Aplikasi ini akan membuat semantic index untuk setiap halamannya ketika kita mengupload pdf file. Saat kita lakukan query, kita akan cek relevansinya dengan data referensi dari dokumen dengan algoritma cosine similarity lalu di urut (ranking) berdasarkan score yang paling tinggi. Lalu beberapa bagian informasi tersebut dijadikan konteks tambahan ketika mengeksekusi prompt user ke model.

Oke kelamaan teori, gimana kalau mau coba nih uda kebelet, silakan:

- Clone projectnya dari https://github.com/Gravicode/PhiPdfRag

- Download file model.onnx dan vocab.txt dari optimum/all-MiniLM-L6-v2 at main (huggingface.co) trus masukin folder “onnx-models/all-MiniLM-L6-v2”

- Download semua file dari microsoft/Phi-3-mini-4k-instruct-onnx at main (huggingface.co) taruh di folder “onnx-models/phi3-directml-int4-awq-block-128”

- Buka pake visual studio, lalu jalanin deh. Upload file pdf, trus tanya-tanya sampe puas puas puassss…

Semoga hari-hari mengoprekmu menyenangkan..

Salam Dev

![]()